¿Cuánto deberían pagar los gobiernos para prevenir las catástrofes?, el papel limitado del largoplacismo

Por: Carl Shulman y Elliot Thornley

*Nota: Este artículo originalmente fue publicado en Oxford University Press, y reproducido en esta pagina con la autorización de los autores y la editorial. La traducción elaborada por el equipo de Tlön. Versión original disponible en este enlace.

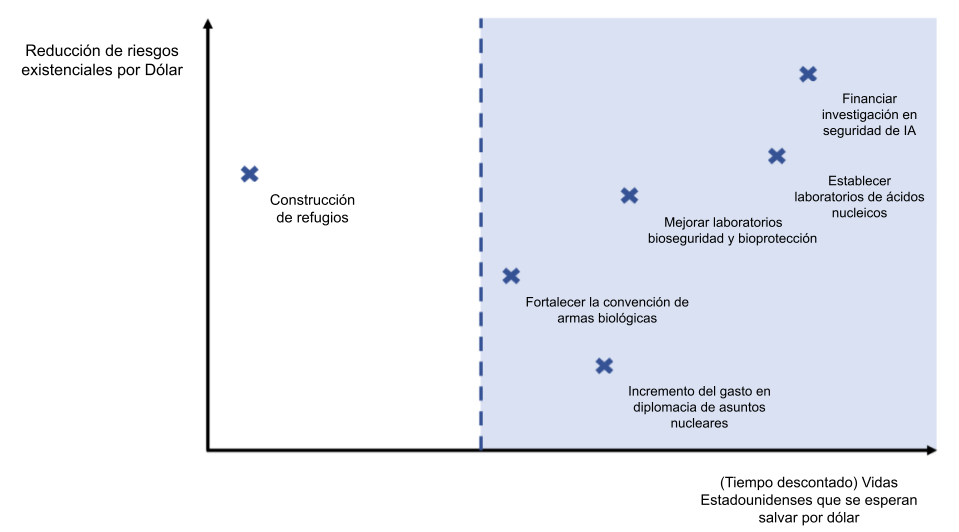

Gráfico 1. Alineación entre una política basada en el ACB y una política largoplacista fuerte. El eje de abscisas representa las vidas salvadas en Estados Unidos (descontadas en función de cuán lejos en el futuro se salva la vida) en términos esperados por dólar. El eje de ordenadas representa la reducción del riesgo existencial por dólar.

Resumen

Los largoplacistas sostienen que la humanidad debería redoblar sus esfuerzos para prevenir catástrofes como guerras nucleares, pandemias y desastres ocasionados por la inteligencia artificial (IA). Pero un destacado argumento largoplacista va más allá de esta conclusión: el argumento también implica que la humanidad debería reducir el riesgo de una catástrofe existencial incluso a un costo extremo para la generación presente. Esta extralimitación significa que los gobiernos democráticos no pueden utilizar el argumento largoplacista para orientar sus políticas en materia de catástrofes. En este artículo demostramos que la prevención de catástrofes no depende del largoplacismo. El análisis de costo-beneficio estándar implica que los gobiernos deberían gastar mucho más en reducir los riesgos catastróficos. Sostenemos que una política gubernamental de catástrofes guiada por el análisis de costo-beneficio debería ser el objetivo de los largoplacistas en la esfera política. Esta política sería democráticamente aceptable y reduciría el riesgo existencial casi tanto como una política largoplacista fuerte.

1. Introducción

Sería muy malo que la humanidad sufriera una guerra nuclear, una pandemia mortal o una catástrofe ocasionada por la IA. Esto se debe a dos razones principales. La primera es que estas catástrofes podrían matar a miles de millones de personas. La segunda es que podrían causar la extinción humana o el colapso permanente de la civilización.

Los largoplacistas han argumentado que la humanidad debería incrementar sus esfuerzos para evitar guerras nucleares, pandemias y catástrofes ocasionadas por la la IA (Beckstead 2013; Bostrom 2013; Greaves y MacAskill 2021; MacAskill 2022; Ord 2020). [1] Un destacado argumento largoplacista a favor de esta conclusión apela a la segunda razón: estas catástrofes podrían conducir a la extinción humana o al colapso permanente de la civilización y, por tanto, impedir que un enorme número de personas potenciales vivan felices en un buen futuro (Beckstead 2013; Bostrom 2013; Greaves y MacAskill 2021; MacAskill 2022: 8-9; Ord 2020: 43-49). Estos acontecimientos se calificarían entonces de catástrofes existenciales: catástrofes que destruyen el potencial a largo plazo de la humanidad (Ord 2020: 37).

Aunque este argumento largoplacista ha sido convincente para muchos, tiene al menos dos limitaciones: limitaciones que son especialmente graves si la conclusión pretendida es que los gobiernos democráticos deberían incrementar sus esfuerzos para prevenir catástrofes. En primer lugar, el argumento se basa en una premisa que mucha gente rechaza: que sería una pérdida moral inmensa que las generaciones futuras nunca existieran. En segundo lugar, el argumento prueba demasiado. Dadas otras afirmaciones plausibles, basar la política en esta premisa no sólo llevaría a los gobiernos a incrementar sus esfuerzos para prevenir catástrofes. También los llevaría a imponer costos extremos a la generación actual en aras de reducir en un grado minúsculo el riesgo de una catástrofe existencial. Dado que la mayoría de la gente asigna una importancia limitada a la existencia de las generaciones futuras, esta política sería democráticamente inaceptable, por lo que los gobiernos no pueden utilizar el argumento largoplacista para orientar su política de catástrofes.

En este capítulo, ofrecemos un argumento estándar de análisis de costo-beneficio para reducir el riesgo de catástrofes. Mostramos que, a partir de estimaciones plausibles del riesgo catastrófico y de los costos de reducirlo, muchas intervenciones al alcance de los gobiernos pasan la prueba del análisis de costo-beneficio. Por tanto, el argumento a favor de evitar catástrofes no depende del largoplacismo. De hecho, sostenemos que los gobiernos deberían hacer mucho más para reducir el riesgo catastrófico incluso si las generaciones futuras no importan en absoluto. La primera razón por la que una catástrofe sería mala —podrían morir miles de millones de personas— justifica por sí sola acciones que van mucho más allá del statu quo. Este argumento basado en los intereses de las personas del presente evita las dos limitaciones del argumento largoplacista: sólo asume que la generación actual importa y no prueba demasiado. No obstante, al igual que el argumento largoplacista, nuestro argumento implica que los gobiernos deberían hacer mucho más para reducir los riesgos catastróficos.

Por ello, argumentamos que conseguir que los gobiernos adopten una política de catástrofes basada en el análisis de costo-beneficio debería ser el objetivo de los largoplacistas en la esfera política. Esteobjetivo es alcanzable, porque el análisis de costo-beneficio (ACB) ya es una herramienta estándar para la toma de decisiones gubernamentales y porque pasar a una política de catástrofes impulsada por el ACB beneficiaría a la generación presente. Adoptar una política basada en el ACB también reduciría el riesgo de catástrofe existencial casi tanto como adoptar una política largoplacista fuerte basada en la premisa de que sería una pérdida moral inmensa que las generaciones futuras nunca existieran.

Proponemos entonces que la perspectiva largoplacista puede desempeñar un papel complementario en la política gubernamental sobre catástrofes. Los largoplacistas pueden argumentar a favor de su punto de vista y, de este modo, incrementar la disposición de las personas del presente a pagar por bienes largoplacistas puros: bienes que no benefician demasiado a la generación actual pero que mejoran las perspectivas de la humanidad a largo plazo. Entre estos bienes largoplacistas puros se incluyen especialmente los refugios diseñados para ayudar a la civilización a recuperarse de futuras catástrofes. Cuando las personas del presente están dispuestas a pagar por estos bienes, los gobiernos deberían financiarlos. Este gasto tendría costos modestos para los que viven hoy grandes beneficios esperados para el futuro a largo plazo.

Concluimos el artículo argumentando que los largoplacistas deberían comprometerse a actuar en la esfera política de acuerdo con una política de catástrofes basada en el ACB. Este compromiso ayudaría a conseguir un resultado mucho mejor que el statu quo, tanto para la generación presente como para el futuro a largo plazo.

2. El riesgo de una catástrofe

Como ya hemos señalado, vamos a utilizar el análisis de costo-beneficio convencional para argumentar a favor de un mayor gasto público en la prevención de catástrofes [2]. Nos centramos en el gobierno de EE.UU., pero nuestros argumentos se aplican también a otros países (con modificaciones que se aclararán más adelante). También nos centramos en el riesgo de catástrofes globales, que definimos como un acontecimiento en el que mueren al menos a 5.000 millones de personas. Muchos acontecimientos podrían constituir una catástrofe global en los próximos años, pero nos centramos en tres en particular: las guerras nucleares, las pandemias y los desastres ocasionados por la IA. Reducir el riesgo de estas catástrofes es particularmente costo-eficaz.

Lo primero que hay que establecer es que el riesgo es significativo. Esto plantea una dificultad. Nunca ha habido una catástrofe global en el sentido de nuestra definición, por lo que no podemos basar nuestras estimaciones del riesgo en frecuencias a largo plazo. Pero esta dificultad es superable porque podemos utilizar otras consideraciones para guiar nuestras estimaciones. Entre ellas se encuentran los cuasi accidentes (como la crisis de los misiles de Cuba), los modelos estadísticos (como las extrapolaciones de ley potencial) y las tendencias empíricas (como los avances en IA). No disponemos de espacio para evaluar en detalle todas las consideraciones pertinentes, por lo que nos basamos principalmente en estimaciones de los riesgos publicadas previamente. Estas estimaciones deberían ser nuestro punto de partida, a la espera de una investigación más detallada. Obsérvese también que no es necesario que estas estimaciones sean perfectamente exactas para que nuestras conclusiones se sigan. A menudo basta con que los riesgos superen algún valor bajo.

Empecemos por el riesgo de guerra nuclear. Toby Ord estima que el riesgo existencial de una guerra nuclear en los próximos 100 años es de aproximadamente 1 entre 1.000 (2020: 167). Nótese, sin embargo, que "riesgo existencial" se refiere al riesgo de una catástrofe existencial: una catástrofe que destruye el potencial a largo plazo de la humanidad. Se trata de un listón muy alto. Significa que cualquier catástrofe de la que la humanidad se recupere alguna vez (aunque esa recuperación lleve muchos milenios) no cuenta como catástrofe existencial. Las guerras nucleares pueden ser enormemente destructivas sin llegar a constituir una catástrofe existencial, por lo que la estimación de Ord del riesgo de una guerra nuclear "a gran escala" es mucho mayor, en torno al 5% en los próximos 100 años (Wiblin y Ord 2020). Esta cifra coincide aproximadamente con nuestras propias opiniones (en torno al 3%) y con otras estimaciones publicadas sobre el riesgo nuclear. En el momento de escribir estas líneas, la comunidad de pronosticadores Metaculus estima que el riesgo de guerra termonuclear antes de 2070 es del 11% (Metaculus 2022c)[3]. La agregación de estimaciones de expertos y superpronosticadores realizada por Luisa Rodríguez (2019b) estima que el riesgo de guerra nuclear entre EE.UU. y Rusia es del 0,38% anual, mientras que Martin E. Hellman (2008: 21) estima que el riesgo anual de guerra nuclear entre EE.UU. y Rusia derivado de un escenario del tipo de la crisis de los misiles de Cuba es del 0,02-0,5%.

Reconocemos que cada una de estas estimaciones implica juicios debatibles. Sin embargo, consideramos que sería insensato suponer que el riesgo real de guerra nuclear en este siglo es inferior al 1%. A continuación presentamos una serie de razones que justifican la cautela. Las armas nucleares han sido una amenaza durante sólo una vida humana, y en esos años ya hemos acumulado un número alarmante de incidentes que estuvieron muy cerca de ser una catástrofe. La crisis de los misiles de Cuba es el ejemplo más famoso, pero también tenemos relatos desclasificados de muchos accidentes y falsas alarmas (véase, por ejemplo, Ord 2020, Apéndice C). Y aunque un conflicto nuclear sería probablemente devastador para todas las partes implicadas, los líderes suelen tener incentivos egoístas para adoptar políticas arriesgadas y pueden comportarse de forma irracional bajo presión. De cara al futuro, los avances tecnológicos pueden alterar el delicado equilibrio basado en la disuasión. Y no podemos dar por sentado que una guerra nuclear sólo perjudicaría a sus destinatarios directos. La investigaciones sugieren que el humo de las ciudades en llamas tardaría años en disiparse, tiempo durante el cual las temperaturas globales y las precipitaciones descenderían lo suficiente como para destruir la mayoría de los cultivos [4], lo que lleva a Rodríguez (2019a) a estimar que un intercambio nuclear entre Estados Unidos y Rusia causaría una hambruna que provocaría, en términos esperados, la muerte de 5.500 millones de personas. Uno de nosotros (Shulman) estima un menor riesgo de este tipo de *invierno nuclear*, un menor número promedio de ojivas nucleares utilizadas en un intercambio nuclear entre Estados Unidos y Rusia, y una mayor probabilidad de que las medidas de emergencia logren reducir el alcance de una hambruna masiva, pero seguimos estimando el número esperado de víctimas en los miles de millones.

Las pandemias causadas por patógenos que han sido diseñados en un laboratorio son otra preocupación importante. Ord (2020: 167) estima que el riesgo existencial durante el próximo siglo de estas pandemias artificiales es de alrededor del 3%. Y al igual que ocurre con la guerra nuclear, las pandemias artificiales podrían ser extremadamente destructivas sin constituir una catástrofe existencial, por lo que la estimación de Ord del riesgo de catástrofe global resultante de una pandemia artificial debería ajustarse hacia arriba a partir de esta cifra del 3%. En el momento de escribir estas líneas, Metaculus sugiere que existe una probabilidad del 9,6% de que, antes de 2100, un patógeno manipulado provoque una reducción de la población humana de al menos un 10% en un periodo de 5 años o menos [5]. En una encuesta realizada en 2008 entre los participantes en una conferencia sobre catástrofes globales, el encuestado medio estimó una probabilidad del 10% de que una pandemia manipulada provoque la muerte de al menos 1.000 millones de personas y una probabilidad del 2% de que una pandemia manipulada provoque la extinción humana antes de 2100 (Sandberg y Bostrom 2008).

Estas estimaciones se basan en un gran número de factores, de los que haremos aquí una breve selección. Las enfermedades pueden ser muy contagiosas y muy mortales [6]. No hay ninguna razón de peso para suponer que las enfermedades manipuladas no puedan ser ambas a la vez. Los científicos siguen realizando investigaciones en las que se modifican patógenos para mejorar su transmisibilidad, letalidad y resistencia al tratamiento (Millett y Snyder-Beattie 2017: 374; Ord 2020: 128-29). También tenemos numerosos informes de fugas de laboratorio: casos en los que se han liberado accidentalmente patógenos en centros de investigación biológica que infectaron a poblaciones humanas (Ord 2020: 130-31). Muchos países desarrollaron programas de armas biológicas durante el siglo XX, y se utilizaron armas biológicas en ambas guerras mundiales (Millett y Snyder-Beattie 2017: 374). Grupos terroristas como la secta Aum Shinrikyo han intentado utilizar agentes biológicos para causar muertes a gran escala (Millett y Snyder-Beattie 2017: 374). Sus esfuerzos se vieron obstaculizados por falta de tecnología y experiencia, pero la capacidad colectiva de la humanidad para el bioterrorismo ha crecido considerablemente desde entonces. En la actualidad, un número significativo de personas tiene la capacidad de provocar una catástrofe biológica, y parece que esta cifra seguirá aumentando en los próximos años (Ord 2020: 133-34).

Ord (2020: 167) estima que el riesgo existencial derivado de la inteligencia artificial general (IAG) es del 10% durante el próximo siglo. Esta cifra es el producto de una probabilidad del 50% de IAG de nivel humano antes de 2120 y un riesgo del 20% de catástrofe existencial asumiendo IAG de nivel humano antes de 2120 (Ord 2020: 168-69). Por su parte, Joseph Carlsmith (2021: 49) estima en un 65% la probabilidad de que en 2070 sea posible y económicamente viable construir sistemas de IA capaces de planificar, elaborar estrategias y superar a los humanos en ámbitos importantes. Carlsmith estima que el riesgo de que estos sistemas causen una catástrofe existencial antes de 2070 es superior al 10% (2021: 47). El pronóstico agregado de una encuesta reciente entre investigadores de aprendizaje automático es una probabilidad del 50% de inteligencia artificial de alto nivel antes de 2059 (Stein-Perlman, Weinstein-Raun y Grace, 2022) [7]. El participante medio en esa encuesta estimó en un 5% la probabilidad de que la IA provoque la extinción humana o la pérdida permanente y grave de poder de la humanidad (Stein-Perlman et al., 2022). Nuestras estimaciones se acercan más a las de Carlsmith y los encuestados en lo que respecta a los plazos y a las de Ord en lo que se refiere al riesgo existencial.

Estas estimaciones son las más especulativas: las armas nucleares y los patógenos artificiales ya existen en el mundo, mientras que la IAG de nivel humano aún está por llegar. En este capítulo no podemos presentar un argumento completo sobre el riesgo de catástrofe ocasionado por la IA, pero a continuación ofrecemos un esbozo. Las capacidades de la IA están creciendo rápidamente, impulsadas en parte por las rápidas mejoras algorítmicas y, sobre todo, por el aumento de los presupuestos para el poder de cómputo. Antes de 2010, el gasto de cómputo en el entrenamiento de modelos de IA crecía en línea con la ley de Moore, pero en la reciente explosión del aprendizaje profundo ha aumentado mucho más rápido, con un tiempo medio de duplicación de seis meses durante ese periodo (Sevilla et al. 2022). Los modelos más grandes y los entrenamientos más largos han dado lugar a avances notables en ámbitos como la visión artificial, el lenguaje, la modelización de proteínas y los juegos. Es probable que en los próximos 20 años veamos los primeros sistemas de IA cercanos a la escala computacional del cerebro humano, a medida que el hardware mejore y el gasto en series de entrenamiento siga incrementándose, pasando de los millones de dólares actuales a muchos miles de millones de dólares (Cotra 2020: 1-9, 2022). La extrapolación de tendencias pasadas sugiere que estos sistemas de IA también podrían tener capacidades equiparables a las del cerebro humano en una amplia gama de dominios.

Los desarrolladores de IA entrenan sus sistemas utilizando una función de recompensa (o función de pérdida) que asigna valores a los resultados del sistema, junto con un algoritmo que modifica el sistema para que funcione mejor según la función de recompensa. Pero codificar las intenciones humanas en una función de recompensa ha resultado extremadamente difícil, como ponen de manifiesto los numerosos casos registrados de sistemas de IA que logran una alta recompensa comportándose de formas no previstas por sus diseñadores (DeepMind 2020; Krakovna 2018). Estos incluyen sistemas que pausan el Tetris para siempre para evitar perder (Murphy 2013), utilizan trucos de cámara para engañar a los evaluadores humanos haciéndoles creer que una mano robótica está completando una tarea (DeepMind 2020; OpenAI 2017) y se comportan de manera diferente bajo observación para evitar penalizaciones por reproducción (Lehman et al. 2020: 282; Muehlhauser 2021). También tenemos casos documentados en los que las IA adoptan objetivos que producen una alta recompensa durante el entrenamiento, pero que difieren en aspectos importantes de los objetivos previstos por sus diseñadores (Langosco et al. 2022; Shah et al. 2022). Un ejemplo es el de un modelo entrenado para ganar un videojuego atrapando una moneda a la derecha del escenario. El modelo mantuvo su capacidad de navegar por el entorno cuando se movió la moneda, pero quedó claro que el objetivo real del modelo era ir lo más lejos posible hacia la derecha, en lugar de atrapar la moneda (Langosco et al. 2022: 4). Hasta ahora, estos problemas de manipulación de la recompensa y generalización errónea de objetivos han tenido poca importancia, porque hemos sido capaces de apagar los sistemas que se comportaban mal o alterar sus funciones de recompensa. Pero parece que esto va a cambiar a medida que los sistemas de IA empiecen a comprender el mundo y a actuar en él: una IAG poderosa podría comprender que dejarse apagar o modificar es una mala forma de conseguir sus objetivos. Y dada una amplia variedad de objetivos, este tipo de IAG tendría motivos para obtener buenos resultados en el entrenamiento y ocultar su objetivo real hasta tanto los sistemas de IAG fueran lo suficientemente poderosos como para tomar control de sus procesos de recompensa (o perseguir sus objetivos) y vencer cualquier respuesta humana.

Esta es una de las formas en las que una IAG desalineada podría ser desastrosa para la humanidad. Para evitar este resultado, probablemente sea necesario dedicar mucho más esfuerzo a alinear de manera sólida la IA con las intenciones humanas, así como introducir la IA avanzada con cautela para permitir la adopción de ingeniería y pruebas de seguridad adecuadas. Desgraciadamente, los incentivos económicos y geopolíticos pueden llevar a que se tenga mucho menos cuidado del necesario. Las empresas y naciones en competencia pueden tomar atajos y exponer a la humanidad a graves riesgos en una carrera por crear una IAG (Armstrong, Bostrom y Shulman, 2016). El riesgo se ve exacerbado por la dinámica de la maldición del ganador: en igualdad de condiciones, los actores que más subestiman los peligros de lanzar una IA avanzada son los que más probablemente terminen por hacerlo (Bostrom, Douglas y Sandberg 2016).

Suponiendo que se trata de eventos independientes y combinando las estimaciones de riesgo de Ord del 10% para la IA, el 3% para las pandemias artificiales y el 5% para la guerra nuclear, obtenemos al menos un 17% de riesgo de catástrofe global por estas tecnologías en los próximos 100 años [8]. Si suponemos que el riesgo por década es constante, el riesgo en la próxima década es de aproximadamente 1,5% [9]. Si suponemos también que el riesgo de muerte en este tipo de catástrofe es el mismo para cada persona, entonces (siempre que no muera de otra forma) el riesgo para cada ciudadano estadounidense de morir en este tipo de catástrofe en la próxima década es de al menos 5 / 9 × 1,85 %. ≈ 1.03% (ya que, según nuestra definición, una catástrofe global provocaría la muerte de al menos 5.000 millones de personas, y se prevé que la población mundial se mantendrá por debajo de los 9.000 millones hasta 2033). Según las proyecciones de la pirámide de población de EE.UU., el 6,88% de los ciudadanos estadounidenses vivos en la actualidad morirán de otras formas en el transcurso de la próxima década [10], lo que sugiere que los ciudadanos estadounidenses vivos en la actualidad tienen un riesgo medio del 1% de morir en una guerra nuclear, una pandemia artificial o un desastre ocasionado por la IA en la próxima década. Eso es aproximadamente diez veces el riesgo de morir en un accidente de coche [11].

3. Intervenciones para reducir el riesgo

Hay buenas razones para suponer que el riesgo de catástrofe global en los próximos años es significativo. Basándonos en las estimaciones de Ord, sugerimos que el riesgo de los ciudadanos estadounidenses de morir en una guerra nuclear, en una pandemia o en un desastre ocasionado por la IA en la próxima década es, por término medio, de alrededor del 1%. A continuación analizamos algunas formas de reducir este riesgo.

El Presupuesto 2023 de la administración Biden enumera muchas formas de reducir el riesgo de catástrofes biológicas (Casa Blanca 2022c; Oficina de Administración y Presupuesto de EE.UU. 2022). Entre ellas se incluye el desarrollo de equipos de protección personal avanzados, junto con prototipos de vacunas para las familias de virus con más probabilidades de causar pandemias [12]. El gobierno estadounidense también puede mejorar la bioseguridad de los laboratorios, mejorando los procedimientos de entrenamiento, las evaluaciones de riesgo y el equipamiento (Bipartisan Commission on Biodefense 2021: 24). Otra prioridad es mejorar nuestras capacidades de análisis forense microbiano (incluida nuestra capacidad para detectar patógenos artificiales), a fin de poder identificar y disuadir mejor a posibles actores malintencionados (Comisión Bipartidista sobre Biodefensa 2021: 24-25). En relación con esto, el gobierno de Estados Unidos puede reforzar la Convención sobre las Armas Biológicas incrementando el presupuesto y el personal del organismo responsable de su aplicación, y trabajando para otorgarle el poder de investigar presuntas infracciones (Ord 2020: 279-80). La Nuclear Threat Initiative recomienda establecer una entidad global centrada en la prevención de catástrofes derivadas de la biotecnología, entre otras cosas (Nuclear Threat Initiative 2020a: 3). Otra prioridad clave es el desarrollo de tecnologías de diagnóstico capaces de detectar cualquier patógeno. Una de estas tecnologías candidatas es un Observatorio del Ácido Nucleico, que vigilaría las vías fluviales y las aguas residuales en busca de frecuencias cambiantes de agentes biológicos, lo que permitiría detectar posibles amenazas biológicas de forma temprana (The Nucleic Acid Observatory Consortium 2021).

El gobierno estadounidense también puede reducir el riesgo de una guerra nuclear en esta década. Ord (2020: 278) recomienda reactivar el Tratado sobre Fuerzas Nucleares de Rango Intermedio, retirar los misiles balísticos intercontinentales estadounidenses del estado de alerta instantáneo ("lanzamiento en caso de alarma") y aumentar la capacidad del Organismo Internacional de Energía Atómica para verificar que los países cumplen los acuerdos de seguridad. Otras recomendaciones proceden del informe “Future Proof” (2021) del Centre for Long-Term Resilience. Están dirigidas al gobierno del Reino Unido, pero se aplican también a Estados Unidos. Las recomendaciones incluyen comprometerse a no incorporar sistemas de IA al mando, control y comunicaciones nucleares (NC3) y presionar para establecer esta norma a nivel internacional [13]. Otra es comprometerse a evitar las operaciones cibernéticas que tengan como objetivo el NC3 de los firmantes del Tratado de No Proliferación Nuclear y establecer un acuerdo multilateral a tal efecto. La Nuclear Threat Initiative (2020b) ofrece muchas recomendaciones a la administración Biden para reducir el riesgo nuclear, algunas de las cuales ya han sido adoptadas [14]. Otras incluyen trabajar para que entre en vigor el Tratado de Prohibición Completa de los Ensayos Nucleares, restablecer los límites del Plan de Acción Integral Conjunto sobre la actividad nuclear de Irán y aumentar los esfuerzos diplomáticos de Estados Unidos con Rusia y China (Nuclear Threat Initiative 2020b)[15].

Para reducir los riesgos ocasionados por la IA, el gobierno estadounidense puede financiar la investigación en seguridad de la IA. Esto debería incluir la investigación sobre la alineación centrada en reducir el riesgo de una toma de poder catastrófica por parte de la IA garantizando que incluso los sistemas de IA muy potentes hagan lo que deseamos, así como la investigación sobre la interpretabilidad para ayudarnos a comprender el comportamiento de las redes neuronales y supervisar mejor su entrenamiento (Amodei et al. 2016; Hendrycks et al. 2022). El gobierno de Estados Unidos también puede financiar la investigación y el trabajo en la gobernanza de la IA, centrado en la elaboración de normas, políticas e instituciones para garantizar que el desarrollo de la IA sea beneficioso para la humanidad (Dafoe 2018).

4. Análisis de costo-beneficio de las intervenciones de prevención de catástrofes

Proyectamos que la financiación de este conjunto de intervenciones durante la próxima década costaría menos de 400.000 millones de dólares [16]. También esperamos que este conjunto de intervenciones reduzca el riesgo de una catástrofe global durante la próxima década en al menos 0,1pp (puntos porcentuales). Una defensa completa de esta afirmación requeriría más detalles de los que caben en este artículo, pero a continuación ofrecemos una manera de ilustrar su plausibilidad. Imaginemos un enorme conjunto de mundos como el nuestro en 2023. Cada mundo en este conjunto es diferente con respecto a las características de nuestro mundo sobre las que tenemos incertidumbre, y los mundos con una determinada característica se producen en el conjunto en proporción a nuestra mejor evidencia sobre la presencia de esa característica en nuestro mundo. Si, por ejemplo, la mejor interpretación de la evidencia disponible sugiere que existe una probabilidad del 55% de que el próximo presidente de EE.UU. sea un demócrata, entonces el 55% de los mundos de nuestro conjunto tienen a un demócrata como próximo presidente. Afirmamos que *en al menos 1 de cada 1.000 de estos mundos* las intervenciones que recomendamos evitarían una catástrofe global esta década. Es un listón bajo, y nos parece plausible que las intervenciones mencionadas anteriormente lo alcancen. Nuestra pregunta ahora es: dado este perfil de costos y beneficios, ¿superan estas intervenciones una prueba estándar de análisis de costo-beneficio?

Para evaluar las intervenciones que se espera salven vidas, el análisis de costo-beneficio comienza por evaluar las reducciones del riesgo de mortalidad: asignar un valor monetario a la reducción del riesgo de muerte de los ciudadanos (Kniesner y Viscusi 2019). Para ello, primero se determina cuánto está dispuesta a pagar una muestra representativa de ciudadanos para reducir el riesgo de morir este año en un incremento determinado (a menudo en torno a 0,01pp, o 1 en 10.000). Uno de los métodos consiste en preguntarles, lo que nos da sus preferencias declaradas. Otro método consiste en observar su comportamiento, sobre todo sus decisiones sobre qué comprar y qué trabajos aceptar, lo que nos da sus preferencias reveladas [17].

Los organismos públicos estadounidenses utilizan métodos de este tipo para estimar cuánto están dispuestos a pagar los ciudadanos por reducir su riesgo de muerte [18]. Esta cifra se utiliza para calcular el valor de una vida estadística (VVE): el valor de salvar una vida en términos esperados mediante pequeñas reducciones del riesgo de mortalidad para muchas personas. La cifra principal del VVE utilizada por el Departamento de Transporte de EE.UU. para 2021 es de 11,8 millones de dólares, con una margen para tener en cuenta diversos tipos de incertidumbre que oscila entre los 7 y los 16,5 millones de dólares (Departamento de Transporte de EE.UU. 2021a, 2021b) [19]. Estas cifras se utilizan en los análisis de costo-beneficio de las políticas que se espera salven vidas. Los costos y beneficios que se produzcan en el futuro se descuentan a una tasa anual constante. La Agencia de Protección Ambiental (EPA) utiliza tasas de descuento anuales del 2% y el 3%; la Oficina de Información y Asuntos Reguladores (OIRA) recomienda a las agencias que realicen análisis utilizando tasas de descuento anuales del 3% y el 7% (Graham 2008: 504).

El motivo son los costos de oportunidad y la tasa de preferencia temporal pura de las personas (Graham 2008: 504). Pasemos ahora a la aplicación al riesgo de una catástrofe global (también conocido como riesgo catastrófico global, o RCG). Antes hemos definido una catástrofe global como un evento que provoca la muerte de al menos 5.000 millones de personas, y hemos supuesto que el riesgo de cada persona de morir en una catástrofe global es el mismo. Así pues, con una población mundial inferior a 9.000 millones de personas y bajo la condición de que se produzca una catástrofe global, el riesgo de cada estadounidense de morir en esa catástrofe es de al menos 5/9. Reducir el RCG en esta década en 0,1pp reduce el riesgo de muerte de cada estadounidense en esta década en al menos 0,055pp. Multiplicando esta cifra por la población estadounidense de 330 millones de habitantes, obtenemos el resultado de que reducir el RCG esta década en 0,1pp salva al menos 181.500 vidas estadounidenses en términos esperados. Si esa reducción del RCG se produjera este año, tendría un valor de al menos 1,27 billones de dólares según la cifra más baja del VVE del Departamento de Transporte, de 7 millones de dólares. Pero dado que la reducción del RCG se produciría a lo largo de una década, el análisis de costo-beneficio exige que hagamos un descuento.

Si utilizamos el tipo de descuento anual más alto de la OIRA (7%) y suponemos (de forma conservadora) que todos los costos de nuestras intervenciones se pagan por adelantado mientras que la reducción del RCG sólo se produce al final de la década, obtenemos el resultado de que reducir el RCG esta década en 0,1pp tiene un valor de al menos 1,27 billones de dólares / 1.07^10 = 646.000 millones de dólares.

Así pues, con un costo de 400.000 millones de dólares, estas intervenciones pasan cómodamente la prueba estándar del análisis de costo-beneficio [20], lo que a su vez sugiere que el gobierno estadounidense debería financiarlas. Si lo hiciera, salvaría vidas estadounidenses de forma más costo-eficaz que muchas otras formas de gasto público para salvar vidas, como el transporte y las normativas medioambientales.

De hecho, podemos ofrecer un argumento más sólido. Utilizando una pirámide de población estadounidense proyectada y algunas estadísticas de esperanza de vida, podemos calcular que aproximadamente el 79% de los años de vida de estadounidenses salvados mediante la prevención de una catástrofe global en 2033 corresponderían a estadounidenses vivos hoy, en 2023 (Thornley 2022). El 79% de 646.000 millones de dólares son aproximadamente 510.000 millones de dólares. Esto significa que la financiación de este conjunto de intervenciones para reducir el RCG bien lo vale, incluso teniendo en cuenta sólo los beneficios para los estadounidenses que viven hoy [21].

También merece la pena señalar algunos aspectos importantes en los que nuestros cálculos hasta este punto subestiman el valor de las intervenciones para reducir el RCG. En primer lugar, hemos apelado únicamente a los beneficios de estas intervenciones para reducir el RCG: los beneficios de alejar la masa de probabilidad de resultados en los que mueren al menos 5.000 millones de personas y acercarla a resultados en los que mueren muy pocas personas. Pero estas intervenciones también reducirían el riesgo de catástrofes menores, en las que mueren menos de 5.000 millones de personas [22]. En segundo lugar, el valor de prevenir las muertes por catástrofe es plausiblemente mayor que el valor de prevenir las muertes por tráfico. La EPA (2010: 20-26) y el Tesoro del Reino Unido (2003: 62) han recomendado que se utilice un VVE más alto para los riesgos de cáncer que para los riesgos de accidentes, para reflejar el hecho de que morir de cáncer tiende a ser más desagradable que morir en un accidente (Kniesner y Viscusi 2019: 16). Sugerimos que el mismo punto se aplica a la muerte por invierno nuclear y pandemias artificiales. He aquí otro beneficio de las intervenciones de reducción del RCG que hemos enumerado.

No solo reducen el riesgo de muerte de los ciudadanos estadounidenses. También reducen el riesgo de muerte de los ciudadanos de otros países. Esta es una razón adicional para financiar estas intervenciones [23]. También sugiere que el gobierno de Estados Unidos podría persuadir a otras naciones para que compartan los costos de las intervenciones que reducen el RCG, en cuyo caso la financiación de estas intervenciones se convierte en una forma aún más costo-eficaz de salvar vidas en Estados Unidos. La cooperación entre naciones también puede hacer que merezca la pena que Estados Unidos y el mundo en su conjunto gasten más en reducir el RCG. Supongamos, por ejemplo, una intervención que costara 1 billón de dólares y redujera el RCG en 0,1 puntos porcentuales durante la próxima década. Eso es demasiado caro para Estados Unidos solo (al menos según nuestros cálculos conservadores), pero valdría la pena ser financiado por una coalición de naciones que acordaran dividir los costos.

5. Los largoplacistas deben abogar por una política de catástrofes impulsada por el ACB

Estados Unidos gasta muy poco en prevención de catástrofes. Esta conclusión se desprende del análisis de costo-beneficio estándar. No hace falta ser largoplacista para pensar que el gobierno estadounidense debería hacer mucho más para reducir el riesgo de guerras nucleares, pandemias y desastres ocasionados por la IA. De hecho, incluso los estadounidenses completamente autointeresados tienen motivos para desear que el gobierno de Estados Unidos incremente sus esfuerzos para evitar catástrofes. Las intervenciones que recomendamos más arriba bien lo valen, incluso considerando sólo los beneficios para los estadounidenses vivos de hoy. Si se tienen en cuenta los beneficios para los ciudadanos de otras naciones y para la próxima generación, estas intervenciones resultan aún más atractivas. Así pues, los estadounidenses deberían esperar que el gobierno de EE.UU. adopte algo parecido a una política de catástrofes basada en el análisis costo-beneficio: una política de financiar todas aquellas intervenciones de reducción del RCG que pasen la prueba del análisis de costo-beneficio.

Se podría pensar que los largoplacistas deberían ser más ambiciosos: en lugar de presionar para que se adopte una política de catástrofes basada en el ACB, los largoplacistas deberían instar a los gobiernos a adoptar una política largoplacista fuerte. Por "política largoplacista fuerte" entendemos una política basada en la premisa de que sería una pérdida moral inmensa que las generaciones futuras nunca existieran [24]. Sin embargo, nosotros sostenemos que no es así: los largoplacistas deberían abogar por una política de catástrofes basada en el ACB en lugar de una política largoplacista fuerte. Esto se debe a que (1) a diferencia de una política largoplacista fuerte, una política basada en el ACB sería democráticamente aceptable y factible de llevar a cabo, y (2) una política basada en el ACB reduciría el riesgo existencial casi tanto como una política largoplacista fuerte [25].

Empecemos por la aceptabilidad democrática. Como ya se ha señalado, una política largoplacista fuerte supondría, en principio, cargas extremas para la generación presente con tal de reducir el riesgo existencial aun en un grado minúsculo. Veamos a grandes rasgos por qué. Si la no existencia de las generaciones futuras fuera una pérdida moral inmensa, entonces una catástrofe existencial (como la extinción humana o el colapso permanente de la civilización) sería un acontecimiento extremadamente malo. Esto hace que merezca la pena reducir el riesgo de una catástrofe existencial, incluso si resulta sumamente costoso para la generación presenten [26].

A continuación argumentamos que una política largoplacista fuerte supondría una carga considerable para la generación presente, no sólo en principio, sino también en la práctica. Hay una serie de intervenciones para reducir el riesgo existencial que los gobiernos sólo podrían llevar a cabo a un costo extremo para los que viven hoy. Por ejemplo, los gobiernos podrían ralentizar el desarrollo de tecnologías que aumentan el riesgo existencial (incluso las que sólo plantean riesgos mínimos) pagando a los investigadores grandes salarios para que se dediquen a otras actividades. Los gobiernos también podrían construir numerosas colonias autosuficientes (en lugares remotos o quizá bajo tierra) en las que los residentes estuvieran permanentemente aislados del resto del mundo y entrenados para reconstruir la civilización en caso de producirse una catástrofe. El gobierno de Estados Unidos podría crear un Observatorio Mundial de Ácido Nucleico, pagando a otros países grandes cantidades (si fuera necesario) para permitir que Estados Unidos controle sus suministros de agua en busca de patógenos emergentes. En términos más generales, los gobiernos podrían subvencionar fuertemente la inversión, la investigación y el desarrollo de forma que se incentive a la generación presente para que incremente la resiliencia de la civilización y disminuya el riesgo existencial. Una política largoplacista fuerte trataría de aplicar estas y otras intervenciones con rapidez, un factor que eleva todavía más los gastos. A su vez, estos gastos requerirían aumentar los impuestos a los ciudadanos actuales (especialmente los impuestos al consumo), así como recortar formas de gasto público que tienen poco efecto sobre el riesgo existencial (como la Seguridad Social, muchos tipos de atención médica y la financiación de parques, las artes, la cultura y el deporte). Estos cambios presupuestarios serían onerosos para quienes viven hoy. Una regulación muy cautelosa del desarrollo tecnológico también impondría cargas. Podría significar que los ciudadanos actuales se perdieran tecnologías que mejorarían y alargarían sus vidas, como bienes de consumo y curas de enfermedades.

Así pues, una política largoplacista fuerte sería "democráticamente inaceptable", es decir, no podría ser adoptada y mantenida por un gobierno democrático. Si un gobierno intentara adoptar una política largoplacista fuerte, perdería el apoyo de la mayoría de sus ciudadanos. Existen claras objeciones morales a la aplicación de políticas democráticamente inaceptables, pero incluso dejándolas de lado, conseguir que los gobiernos adopten una política largoplacista fuerte no es factible. Los esfuerzos en esa dirección tienen muy pocas probabilidades de éxito.

En cambio, una política de catástrofes impulsada por el ACB sería democráticamente aceptable. Este tipo de política no supondría una pesada carga para la generación presente. Dado que el análisis de costo-beneficio se basa en gran medida en la disposición a pagar de los ciudadanos, las políticas guiadas por el análisis de costo-beneficio no suelen pedir a los ciudadanos que paguen mucho más de lo que los beneficia personalmente. Y dado nuestro muy reducido gasto actual en prevención de catástrofes, pasar del statu quo a una política guiada por el ACB es casi con toda seguridad bueno para los ciudadanos estadounidenses vivos hoy en día. Esa es una de las razones para pensar que conseguir que el gobierno de Estados Unidos adopte una política basada en el ACB es especialmente factible. Otra es que el análisis de costo-beneficio ya es una herramienta estándar para la toma de decisiones reguladoras en EE.UU. [27] Abogar por una política basada en el ACB no significa pedir a los gobiernos que adopten un procedimiento de toma de decisiones radicalmente nuevo. Sólo significa pedirles que extiendan un procedimiento de toma de decisiones estándar a un ámbito en el que hasta ahora no ha sido suficientemente utilizado.

Por supuesto, lograr que los gobiernos adopten una política de catástrofes basada en el ACB no es una tarea trivial. Uno de los obstáculos es psicológico (Wiener 2016). A muchos de nosotros nos cuesta apreciar la probabilidad y la magnitud de una catástrofe global. Otro es que la reducción del RCG es un problema de acción colectiva para las personas individuales. Aunque un mundo más seguro promueve los intereses de muchos, trabajar por un mundo más seguro promueve los intereses de pocos. Los políticos y los reguladores tampoco tienen incentivos para abogar por intervenciones que reduzcan el RCG (como hicieron con las intervenciones climáticas en décadas anteriores). Dada la ignorancia generalizada de los riesgos, es poco probable que los pedidos de que se adopten este tipo de intervenciones obtengan el favor del público.

Sin embargo, estos obstáculos pueden superarse. Quienes estén dispuestos a asumir costos por el bien de los demás pueden emplear su tiempo y su dinero para llamar la atención sobre la posibilidad de una catástrofe global, fomentando así el apoyo público a las intervenciones para reducir el RCG e incluyéndolas en la agenda política. Los largoplacistas —que se preocupan tanto por la generación presente como por las generaciones futuras— están bien situados para desempeñar este papel y presionar a los gobiernos para que adopten una política de catástrofes basada en el ACB. Si se empeñan en ello, tendrán muchas posibilidades de éxito.

En cuanto al segundo punto, conseguir que el gobierno estadounidense adopte una política de catástrofes basada en el ACB reduciría el riesgo existencial casi tanto como conseguir que adopte una política largoplacista fuerte. Esto es así por dos razones. La primera es que, en el margen actual, los objetivos principales de una política basada en el ACB y una política largoplacista fuerte están estrechamente alineados. La segunda es que un mayor gasto en la prevención de catástrofes produce rendimientos muy decrecientes en términos de reducción del riesgo existencial.

Empecemos por la alineación estrecha. El objetivo principal de una política de catástrofes basada en el ACB es salvar vidas a corto plazo. El objetivo primordial de una política largoplacista fuerte es reducir el riesgo existencial. En el mundo actual, estos objetivos están alineados: muchas de las mejores intervenciones para reducir el riesgo existencial son también intervenciones costo-eficaces para salvar vidas a corto plazo. Tomemos como ejemplo la IA. Según Ord (2020: 167) y muchos otros largoplacistas, el riesgo de la IA constituye una gran parte del riesgo existencial total de este siglo, y este riesgo podría reducirse significativamente trabajando en la seguridad y la gobernanza de la IA. Por ello, esta área ocupa un lugar destacado en la lista de prioridades de muchos largoplacistas. Hemos argumentado anteriormente que una política basada en el ACB también financiaría este tipo de trabajo, ya que es una forma costo-eficaz de salvar vidas a corto plazo. Lo mismo ocurre con las pandemias. Las intervenciones para evitar posibles pandemias ocupan un lugar destacado en la lista de prioridades de los largoplacistas, y estas intervenciones también se llevarían a cabo por una política basada en el ACB.

El gráfico 1. se ilustra la alineación entre una política basada en el ACB y una política largoplacista fuerte. El eje de abscisas representa las vidas salvadas en Estados Unidos (descontadas en función de cuán lejos en el futuro se salva la vida) en términos esperados por dólar. El eje de ordenadas representa la reducción del riesgo existencial por dólar. Las intervenciones a la derecha de la línea azul se financiarían mediante una política de catástrofes basada en el ACB. La posición exacta de cada intervención es provisional y carece de importancia, y en cualquier caso el gráfico no está a escala. Lo importante es que una política basada en el ACB financiaría muchas de las mejores intervenciones para reducir el riesgo existencial.

Esa es la alineación clave entre una política basada en el ACB y una política largoplacista fuerte. Veamos ahora tres diferencias potencialmente significativas. La primera es que una política largoplacista fuerte financiaría lo que llamamos bienes largoplacistas puros: bienes que no benefician mucho a la población presente pero mejoran las perspectivas de la humanidad a largo plazo. Estos bienes largoplacistas puros incluyen refugios para ayudar a la humanidad a recuperarse de catástrofes. La segunda diferencia es que una política largoplacista fuerte gastaría mucho más en prevenir catástrofes que una política basada en el ACB. Además de las intervenciones justificadas por una política de catástrofes basada en el ACB, una política largoplacista fuerte también financiaría intervenciones de prevención de catástrofes que son demasiado caras para pasar la prueba del análisis de costo-beneficio. La tercera diferencia tiene que ver con los riesgos nucleares. El riesgo de una guerra nuclear a gran escala es significativamente mayor que el riesgo de que una guerra nuclear constituya una catástrofe existencial (5% frente a 0,1% este siglo, según Ord). En parte por esta razón, las intervenciones para reducir el riesgo nuclear son costo-eficaces para salvar vidas a corto plazo, pero no tan costo-eficaces para reducir el riesgo existencial [28], lo que hace que estas intervenciones sean relativamente menos prioritarias desde el punto de vista de una política largoplacista fuerte que desde el punto de vista de una política basada en el ACB. Manteniendo fijo el presupuesto para catástrofes previsto por el análisis de costo-beneficio, una política largoplacista fuerte probablemente desviaría parte de la financiación de las intervenciones nucleares hacia intervenciones focalizadas en la IA y las pandemias que no superan la prueba del análisis de costo-beneficio[29].

Dejemos a un lado por ahora los bienes largoplacistas puros. Hablaremos de ellos en la próxima sección. Consideremos en cambio el hecho de que una política largoplacista fuerte gastaría considerablemente más en prevenir catástrofes (especialmente catástrofes relacionadas con la IA y biológicas) que una política basada en el ACB. Argumentamos que este gasto adicional no tendría una incidencia tan significativa en el riesgo existencial, porque un mayor gasto en la prevención de catástrofes produce rendimientos muy decrecientes en términos de reducción del riesgo existencial. Esto se debe a dos razones principales. La primera es que las intervenciones más prometedoras para reducir el riesgo existencial —por ejemplo, la seguridad y la gobernanza de la IA, un Observatorio del Ácido Nucleico, mejoras en las prácticas de bioseguridad- pasan la prueba del análisis de costo—beneficio. Las intervenciones de prevención de catástrofes que no superan la prueba del análisis de costo-beneficio no son ni de cerca tan eficaces para reducir el riesgo existencial.

Una segunda razón para esperar que el aumento del gasto produzca rendimientos decrecientes en términos de reducción del riesgo existencial es que muchas intervenciones se anulan entre sí. Lo que queremos decir con esto es que muchas intervenciones hacen que otras intervenciones sean menos eficaces, de modo que la reducción total del riesgo existencial obtenida financiando algunos conjuntos de intervenciones es menor que la suma de la reducción del riesgo existencial obtenida financiando cada intervención individualmente. Veamos un ejemplo. Dejando a un lado una complicación menor, podemos descomponer el riesgo existencial de los patógenos manipulados en dos factores: el riesgo de que un patógeno manipulado infecte a más de 1.000 personas y el riesgo de una catástrofe existencial en caso de que un patógeno manipulado infecte a más de 1.000 personas[30].Supongamos (sólo a título ilustrativo) que cada riesgo es del 10% esta década, que incentivar a los investigadores biomédicos del mundo para que realicen investigaciones más seguras reduciría a la mitad el primer riesgo, y que establecer un Observatorio del Ácido Nucleico (OAN) reduciría a la mitad el segundo riesgo. Entonces, en ausencia de cualquier intervención, el riesgo existencial esta década derivado de los patógenos de ingeniería es del 1%. Incentivar sólo la investigación segura reduciría el riesgo existencial en un 0,5%. Establecer sólo un OAN reduciría el riesgo existencial en un 0,5%. Pero incentivar la investigación segura después de establecer un OAN reduciría el riesgo existencial en sólo un 0,25%. En términos más generales, la eficacia de las intervenciones de reducción del riesgo existencial que no superan la prueba del análisis de costo-beneficio se vería sustancialmente mermada por todas aquellas intervenciones que sí la superan.

En la actualidad, el mundo gasta muy poco en prevenir catástrofes globales. Estados Unidos gastó aproximadamente 3.000 millones de dólares en bioseguridad en 2019 (Watson et al. 2018), y (a pesar de la llamada de atención que nos dio la COVID-19) la financiación para prevenir futuras pandemias no se ha incrementado mucho desde entonces [31]. Gran parte de este gasto no es apto para combatir las amenazas biológicas más extremas. El gasto destinado a reducir el RCG derivado de la IA es inferior a 100 millones de dólares al año [32]. De modo que los gobiernos tienen muchas oportunidades fáciles de aprovechar: dada el muy reducido gasto actual, la transición a una política de catástrofes impulsada por el ACB reduciría significativamente el riesgo existencial. Los gobiernos podrían reducir aún más el riesgo existencial adoptando una política largoplacista fuerte, pero esta reducción adicional sería comparativamente menor. Lo mismo ocurre si se desvía la financiación del riesgo nuclear hacia la IA y los riesgos de pandemias, al tiempo que se mantiene fijo el nivel de gasto en prevención de catástrofes justificado por el análisis de costo-beneficio. Este cambio tendría sólo un pequeño efecto en el riesgo existencial, porque las mejores intervenciones para reducir los riesgos ocasionados por la IA y a las pandemias ya habrían sido financiadas por una política impulsada por el ACB.

Y, como ya se ha señalado, la cooperación internacional haría que aún más intervenciones de prevención de catástrofes fueran lo suficientemente rentables como para pasar la prueba del análisis de costo-beneficio. Algunas de estas intervenciones adicionales también tendrían efectos no triviales sobre el riesgo existencial. Pensemos en el cambio climático. Algunas intervenciones climáticas son demasiado costosas para que un país que obra en su propio interés las financie unilateralmente, pero son, no obstante, redituables para una coalición de países que se han puesto de acuerdo para actuar de forma coordinada. La transición de los combustibles fósiles a las fuentes de energía renovables es un ejemplo. El cambio climático es también un *factor de riesgo existencial*: un factor que incrementa el riesgo existencial. Además de constituir un pequeño riesgo de causar directamente la extinción humana o el colapso permanente de la civilización, el cambio climático representa un importante riesgo indirecto. Amenaza con exacerbar los conflictos internacionales y empujar a la humanidad a buscar soluciones tecnológicas arriesgadas. Un cambio climático extremo también dañaría nuestra capacidad de recuperación y nos haría más vulnerables a otras catástrofes. Así que, además de tener otros beneficios, mitigar el cambio climático disminuye el riesgo existencial. Dado que un mayor número de intervenciones climáticas pasan la prueba del análisis de costo-beneficio si las naciones se ponen de acuerdo para actuar de forma coordinada, este tipo de cooperación internacional reduciría aún más la diferencia entre el riesgo existencial de una política catastrofista impulsada por el ACB y el de una política largoplacista fuerte.

6. Los bienes largoplacistas puros y la disposición a pagar altruista

Queda una diferencia potencialmente importante entre una política de catástrofes basada en el ACB y una política largoplacista fuerte: una política largoplacista fuerte destinará fondos considerables a lo que llamamos *bienes largoplacistas puros*. Los definimos como bienes que no benefician demasiado a la generación presente pero mejoran las perspectivas de la humanidad a largo plazo. Entre ellos se cuentan especialmente los refugios: grandes estructuras bien equipadas similares a búnkeres, diseñadas para ayudar a sus ocupantes a sobrevivir a futuras catástrofes y reconstruir la civilización posteriormente [33]. Podría parecer que una política de catástrofes basada en el ACB no financiaría bienes largoplacistas puros, porque no son especialmente costo-eficaces para salvar vidas a corto plazo. En caso de una catástrofe grave, los refugios salvarían como mucho a una pequeña parte de las personas vivas actualmente. Pero una política largoplacista fuerte invertiría en refugios porque reducirían significativamente el riesgo existencial. Incluso un grupo relativamente pequeño de sobrevivientes podría volver a sacar a la humanidad a flote, en cuyo caso se habría evitado una catástrofe existencial: la destrucción permanente del potencial de la humanidad a largo plazo. Dado que una política largoplacista fuerte financiaría los refugios, podría parecer que la adopción de una política largoplacista fuerte reduciría el riesgo existencial mucho más que la adopción de una política basada en el ACB.

Sin embargo, incluso esta diferencia entre una política basada en el ACB y una política largoplacista fuerte no tiene por qué ser tan grande. Esto se debe a que el análisis de costo-beneficio debería incorporar (y está empezando a hacerlo) la disposición a pagar de los ciudadanos para hacer valer sus compromisos morales: lo que llamaremos su disposición a pagar altruista (DAPA). Posner y Sunstein (2017) ofrecen argumentos en este sentido. Señalan que los ciudadanos tienen diversos compromisos morales -con respecto al mundo natural, los animales no humanos, los ciudadanos de otras naciones, las generaciones futuras, etc.- y sufren pérdidas de bienestar cuando estos compromisos se ven afectados (2017: 1829-30) [34]. Sostienen que la mejor forma de medir estas pérdidas es la disposición a pagar de los ciudadanos para hacer valer sus compromisos morales, y que esta disposición a pagar debería incluirse en los cálculos de costo-beneficio de las regulaciones propuestas (2017: 1830) [35]. Posner y Sunstein también señalan que existen precedentes normativos y jurídicos para hacerlo (2017: sec. 3) [36].

Y es aquí, creemos, donde el largoplacismo debería intervenir en la política de catástrofes de los gobiernos. Los largoplacistas deberían defender su punto de vista y, de este modo, incrementar la DAPA de los ciudadanos para bienes largoplacistas puros como los refugios [37]. Cuando los ciudadanos estén dispuestos a pagar por estos bienes, los gobiernos deberían financiarlos.

Aunque la aceptación de los nuevos movimientos morales es difícil de predecir (Sunstein 2020), tenemos motivos para ser optimistas sobre este tipo de divulgación largoplacista. Una encuesta reciente sugiere que muchas personas tienen intuiciones morales que podrían inclinarlas hacia una forma débil de largoplacismo: los encuestados tendían a juzgar que es bueno crear personas felices (Caviola et al. 2022: 9). Otra encuesta indica que el mero hecho de dar relevancia al futuro tiene un efecto notable en las opiniones de la gente sobre la extinción humana. Cuando se les pidió que consideraran las consecuencias a largo plazo, la proporción de personas que juzgaron que la extinción humana era especialmente mala en comparación con la casi extinción aumentó del 23% al 50% (Schubert, Caviola y Faber 2019: 3-4). Y cuando se pidió a los encuestados que supusieran que la vida en el futuro será mucho mejor que la vida actual, esa cifra saltó al 77% (Schubert et al. 2019: 4). En el lapso de unas seis décadas, el ecologismo ha pasado de ser un movimiento marginal a una de las principales prioridades morales de nuestro tiempo. Al igual que el largoplacismo, el ecologismo ha estado motivado en gran parte por la preocupación por las generaciones futuras. Los argumentos largoplacistas ya han resultado convincentes para muchas personas, y estos factores sugieren que podrían serlo para muchas más.

Incluso una pequeña DAPA para bienes largoplacistas puros podría tener un efecto significativo sobre el riesgo existencial. Si los ciudadanos estadounidenses están dispuestos a contribuir con sólo 5 dólares al año en promedio, entonces una política impulsada por el ACB que incorpore la DAPA garantiza un gasto de hasta 1.650 millones de dólares al año en bienes largoplacistas puros: suficiente para construir numerosos refugios. Por supuesto, incluso en un escenario en el que cada ciudadano estadounidense se viera expuesto a los argumentos largoplacistas, una política basada en el ACB asignaría menos fondos a los bienes largoplacistas puros que una política largoplacista fuerte. Pero al igual que ocurre con las intervenciones para prevenir catástrofes, parece probable que la reducción marginal del riesgo existencial disminuya drásticamente a medida que aumenta el gasto en bienes largoplacistas puros: tan drásticamente que alcanzar el nivel de gasto en bienes largoplacistas puros garantizado por la DAPA de los ciudadanos reduciría el riesgo existencial casi tanto como alcanzar el nivel de gasto garantizado por una política largoplacista fuerte. Esto es especialmente cierto si varias naciones ofrecen financiar bienes largoplacistas puros en línea con la DAPA de sus ciudadanos.

Queda un último punto por considerar. Podría pensarse que sólo *en el margen actual* y *en público* es cierto que los largoplacistas deberían presionar a los gobiernos para que adopten una política de catástrofes guiada por el análisis de costo-beneficio y la disposición a pagar altruista. Una vez que se hayan financiado todas las intervenciones justificadas por el ACB más la DAPA, los largoplacistas deberían presionar para que los gobiernos gasten aún más en la prevención de catástrofes. Y mientras tanto, los largoplacistas deberían abogar en privado por que los gobiernos financien intervenciones de reducción del riesgo existencial que vayan más allá del ACB más la DAPA.

No estamos de acuerdo. Los largoplacistas pueden intentar que los gobiernos destinen más fondos a la prevención de catástrofes esgrimiendo argumentos largoplacistas y aumentando así la DAPA de los ciudadanos, pero no deben instar a los gobiernos a que se aparten de una política de catástrofes basada en el ACB más la DAPA. Por el contrario, los largoplacistas deberían comprometerse en la medida de lo posible a actuar de acuerdo con una política de ACB más DAPA en la esfera política. Una de las razones es simple: los largoplacistas tienen razones morales para respetar las preferencias de sus conciudadanos.

Para entender otra de las razones, obsérvese en primer lugar que el trabajo de los largoplacistas para mejorar la política gubernamental en materia de catástrofes podría resultar beneficioso para todos. La generación presente se beneficia porque los largoplacistas resuelven el problema de acción colectiva: trabajan para poner en marcha intervenciones que reduzcan de forma costo-eficaz el riesgo de todos de morir en una catástrofe. Las generaciones futuras se benefician porque estas intervenciones también reducen el riesgo existencial. Pero tal y como están las cosas, la generación presente puede temer que los largoplacistas vayan demasiado lejos. Si se les concede un poder del que no siempre deban rendir cuentas, los largoplacistas podrían intentar utilizar la maquinaria del gobierno para imponer cargas a la generación presente en aras de mayores beneficios para las generaciones futuras. Estas preocupaciones pueden llevar a la marginación del largoplacismo y, por tanto, a un resultado peor tanto para las generaciones presentes como para las generaciones futuras.

La mejor solución es el compromiso [38]: una política de ACB más DAPA, basada en las preferencias de los ciudadanos, es aceptable para una amplia coalición de personas. Como resultado, los largoplacistas que se comprometen a actuar de acuerdo con una política de ACB más DAPA hacen posible un acuerdo que es significativamente mejor que el statu quo, desde el punto de vista tanto de los largoplacistas como de la generación presente. El acuerdo también da lugar a otros beneficios de la cooperación. Por ejemplo, ayuda a evitar conflictos innecesarios en los que los grupos presionan a favor de políticas opuestas, de suerte que una parte sustancial de los recursos que un grupo gasta anula los efectos resultantes de los recursos gastados por el otro grupo (véase Ord 2015: 120-21, 135). Con una política de ACB más DAPA, esos recursos pueden gastarse en intervenciones atractivas para todas las partes.

Los largoplacistas pueden aumentar y demostrar de muchas formas su compromiso con este tipo de política de compromiso beneficiosa para todas las partes. Pueden hablar a favor de ella ahora y actuar de acuerdo con ella en la esfera política. También pueden apoyar los esfuerzos para integrar el criterio ACB más DAPA en la toma de decisiones gubernamentales —a través de decretos, estatutos reguladores y leyes—, garantizando así que los gobiernos no gasten ni demasiado ni demasiado poco en beneficios para las generaciones futuras. Los largoplacistas también pueden ganarse la reputación de cooperar bien con los demás, apoyando intervenciones e instituciones que resulten atractivas para un amplio abanico de personas. De este modo, los largoplacistas hacen posible una forma de cooperación sustancialmente beneficiosa tanto para la generación presente como para el futuro a largo plazo.

7. Conclusión

Los gobiernos deberían gastar mucho más en prevenir las amenazas derivadas de la guerra nuclear, las pandemias artificiales y la IA. Esta conclusión se desprende del análisis de costo-beneficio estándar. No es necesario asumir una perspectiva largoplacista, o siquiera que las generaciones futuras importan moralmente. De hecho, incluso los estadounidenses completamente autointeresados tienen motivos para esperar que el gobierno de Estados Unidos adopte una política de catástrofes guiada por el análisis de costo-beneficio.

Los largoplacistas deberían abogar por un objetivo similar: una política de catástrofes del gobierno guiada por el análisis de costo-beneficio y la disposición a pagar altruista de los ciudadanos. Esta política es factible y democráticamente aceptable. También reduciría el riesgo existencial casi tanto como una política largoplacista fuerte. Sobre todo si los largoplacistas consiguen hacer del futuro a largo plazo una de las principales prioridades morales de nuestro tiempo y si la disposición a pagar altruista de los ciudadanos por los beneficios del futuro a largo plazo crece proporcionalmente. Los largoplacistas deberían comprometerse a actuar de acuerdo con una política de ACB más DAPA en la esfera política. Este compromiso ayudaría a conseguir una política de catástrofes mucho mejor que el statu quo, tanto para la generación presente como para el futuro a largo plazo[39].

-

Administración del Seguro Social de EE.UU. (2022). *Actuarial Life Table*. Social Security. <https://www.ssa.gov/oact/STATS/table4c6.html>

Agencia de Protección Ambiental de EE.UU. (2010). *Valuing Mortality Risk Reductions for Environmental Policy: A White Paper (2010)*. <https://www.epa.gov/sites/default/files/2017-08/documents/ee-0563-1.pdf>

Aldy, J. E., and Viscusi, W. K. (2008). 'Adjusting the Value of a Statistical Life for Age and Cohort Effects', in *Review of Economics and Statistics* *90*(3): 573--581.

Amadae, S. M., and Avin, S. (2019). Autonomy and Machine Learning as Risk Factors at the Interface of Nuclear Weapons, Computers and People. In V. Boulanin (Ed.), *The Impact of Artificial Intelligence on Strategic Stability and Nuclear Risk* (Vols 1, Euro-Atlantic Perspectives, pp. 105--118).

Amodei, D., Olah, C., Steinhardt, J., Christiano, P., Schulman, J., and Mané, D. (2016). 'Concrete Problems in AI Safety', *arXiv*. <http://arxiv.org/abs/1606.06565>

Armstrong, S., Bostrom, N., and Shulman, C. (2016). 'Racing to the precipice: A model of artificial intelligence development', in *AI & Society* *31*(2): 201--206.

Baum, S. D. (2015). 'The far future argument for confronting catastrophic threats to humanity: Practical significance and alternatives', in *Futures* *72*: 86--96.

Beckstead, N. (2013). *On the Overwhelming Importance of Shaping the Far Future* \[PhD Thesis, Rutgers University\]. <http://dx.doi.org/doi:10.7282/T35M649T>

Beckstead, N. (2015). 'How much could refuges help us recover from a global catastrophe?', in *Futures* *72*: 36--44.

Bipartisan Commission on Biodefense. (2021). *The Apollo Program for Biodefense: Winning the Race Against Biological Threats*. Bipartisan Commission on Biodefense. <https://biodefensecommission.org/wp-content/uploads/2021/01/Apollo_report_final_v8_033121_web.pdf>

Bipartisan Commission on Biodefense. (2022). *The Athena Agenda: Advancing the Apollo Program for Biodefense*. Bipartisan Commission on Biodefense.<https://biodefensecommission.org/wpcontent/uploads/2022/04/Athena-Report_v7.pdf>

Bostrom, N. (2013). 'Existential Risk Prevention as Global Priority', in *Global Policy* *4*(1): 15--31.

Bostrom, N., Douglas, T., and Sandberg, A. (2016). 'The Unilateralist's Curse and the Case for a Principle of Conformity', in *Social Epistemology* *30*(4): 350--371.

Carlsmith, J. (2021). 'Is Power-Seeking AI an Existential Risk?', *arXiv*.<http://arxiv.org/abs/2206.13353>

Casa Blanca. (2022a). 'A Return to Science: Evidence-Based Estimates of the Benefits of Reducing Climate Pollution'. *Casa Blanca*. <https://www.whitehouse.gov/cea/written-materials/2021/02/26/a-return-to-science-evidence-based-estimates-of-the-benefits-of-reducing-climate-pollution/>

Casa Blanca. (2022b). 'Joint Statement of the Leaders of the Five Nuclear-Weapon States on Preventing Nuclear War and Avoiding Arms Races'. *Casa Blanca*. <https://www.whitehouse.gov/briefing-room/statements-releases/2022/01/03/p5-statement-on-preventing-nuclear-war-and-avoiding-arms-races/>

Casa Blanca. (2022c). 'The Biden Administration's Historic Investment in Pandemic Preparedness and Biodefense in the FY 2023 President's Budget'. *Casa Blanca*.<https://www.whitehouse.gov/briefing-room/statements-releases/2022/03/28/fact-sheet-the-biden-administrations-historic-investment-in-pandemic-preparedness-and-biodefense-in-the-fy-2023-presidents-budget/>

Caviola, L., Althaus, D., Mogensen, A. L., and Goodwin, G. P. (2022). 'Population ethical intuitions', in *Cognition* *218*: 104941.

Centre for Long-Term Resilience. (2021). *Future Proof: The Opportunity to Transform the UK's Resilience to Extreme Risks*. <https://11f95c32-710c-438b-903d-da4e18de8aaa.filesusr.com/ugd/e40baa_c64c0d7b430149a393236bf4d26cdfdd.pdf>

Claxton, K., Ochalek, J., Revill, P., Rollinger, A., and Walker, D. (2016). 'Informing Decisions in Global Health: Cost Per DALY Thresholds and Health Opportunity Costs'. University of York Centre for Health Economics. <https://www.york.ac.uk/media/che/documents/policybriefing/Cost%20per%20DALY%20thresholds.pdf>

Comisión Nacional de Seguridad sobre Inteligencia Artificial. (2021). *Final Report*. <https://www.nscai.gov/wp-content/uploads/2021/03/Full-Report-Digital-1.pdf>

Cotra, A. (2020). 'Forecasting Transformative AI with Biological Anchors, Part 4: Timelines estimates and responses to objections'.<https://docs.google.com/document/d/1cCJjzZaJ7ATbq8N2fvhmsDOUWdm7t3uSSXv6bD0E_GM>

Cotra, A. (2022). 'Two-year update on my personal AI timelines'. *AI Alignment Forum*. <https://www.alignmentforum.org/posts/AfH2oPHCApdKicM4m/two-year-update-on-my-personal-ai-timelines>

Coupe, J., Bardeen, C. G., Robock, A., and Toon, O. B. (2019). 'Nuclear Winter Responses to Nuclear War Between the United States and Russia in the Whole Atmosphere Community Climate Model Version 4 and the Goddard Institute for Space Studies ModelE', in *Journal of Geophysical Research: Atmospheres* *124*(15): 8522--8543.

Cutler, D. M., and Summers, L. H. (2020). 'The COVID-19 Pandemic and the \$16 Trillion Virus', in *Journal of the American Medical Association* *324*(15): 1495--1496.

Dafoe, A. (2018). 'AI Governance: A Research Agenda'. Future of Humanity Institute, University of Oxford.<https://www.fhi.ox.ac.uk/wp-content/uploads/GovAI-Agenda.pdf>

DeepMind. (2020). 'Specification gaming: The flip side of AI ingenuity'. DeepMind.<https://www.deepmind.com/blog/specification-gaming-the-flip-side-of-ai-ingenuity>

Departamento de Transporte de EE.UU. (2021a). *Departmental Guidance on Valuation of a Statistical Life in Economic Analysis*. Departamento de Transporte de EE.UU<https://www.transportation.gov/office-policy/transportation-policy/revised-departmental-guidance-on-valuation-of-a-statistical-life-in-economic-analysis>

Departamento de Transporte de EE.UU. (2021b). *Departmental Guidance: Treatment of the Value of Preventing Fatalities and Injuries in Preparing Economic Analyses*. <https://www.transportation.gov/sites/dot.gov/files/2021-03/DOT%20VSL%20Guidance%20-%202021%20Update.pdf>

Executive Order No. 12,291, Code of Federal Regulations, Title 3 127 (1982).<https://www.govinfo.gov/app/details/CFR-2012-title3-vol1/CFR-2012-title3-vol1-eo13563/summary>

Executive Order No. 13,563, Code of Federal Regulations, Title 3 215 (2012). <https://www.archives.gov/federal-register/codification/executive-order/12291.html>

Favaloro, P., and Berger, A. (2021). 'Technical Updates to Our Global Health and Wellbeing CausePrioritization Framework---Open Philanthropy'. *Open Philanthropy*.<https://www.openphilanthropy.org/research/technical-updates-to-our-global-health-and-wellbeing-cause-prioritization-framework/>

Grace, K., Salvatier, J., Dafoe, A., Zhang, B., and Evans, O. (2018). 'When Will AI Exceed Human Performance? Evidence from AI Experts' in *Journal of Artificial Intelligence Research*, *62*, 729--754.

Graham, J. D. (2008). 'Saving Lives through Administrative Law and Economics', in *University of Pennsylvania Law Review* *157*(2): 395--540.

Greaves, H., and MacAskill, W. (2021). 'The Case for Strong Longtermism'. *GPI Working Paper*, *No. 5-2021.* <https://globalprioritiesinstitute.org/hilary-greaves-william-macaskill-the-case-for-strong-longtermism/>

Hellman, M. E. (2008). 'Risk Analysis of Nuclear Deterrence', in *The Bent of Tau Beta Pi* *99*(2): 14--22.

Hendrycks, D., Carlini, N., Schulman, J., and Steinhardt, J. (2022). 'Unsolved Problems in ML Safety'. *arXiv*. <http://arxiv.org/abs/2109.13916>

Hirth, R. A., Chernew, M. E., Miller, E., Fendrick, A. M., and Weissert, W. G. (2000). 'Willingness to pay for a quality-adjusted life year: In search of a standard', in *Medical Decision Making: An International Journal of the Society for Medical Decision Making* *20*(3): 332--342.

H.R.5376---Inflation Reduction Act of 2022, (2022).<https://www.congress.gov/bill/117th-congress/house-bill/5376>

Jebari, K. (2015). 'Existential Risks: Exploring a Robust Risk Reduction Strategy', in *Science and Engineering Ethics* *21*(3): 541--554.

Kniesner, T. J., and Viscusi, W. K. (2019). 'The Value of a Statistical Life', in *Oxford Research Encyclopedia of Economics and Finance*. Oxford University Press. <https://oxfordre.com/economics/view/10.1093/acrefore/9780190625979.001.0001/acrefore-9780190625979-e-138>

Krakovna, V. (2018). 'Specification gaming examples in AI'. *Victoria Krakovna*.<https://vkrakovna.wordpress.com/2018/04/02/specification-gaming-examples-in-ai/>

Langosco, L., Koch, J., Sharkey, L., Pfau, J., Orseau, L., and Krueger, D. (2022). 'Goal Misgeneralization in Deep Reinforcement Learning'.*arXiv*<http://arxiv.org/abs/2105.14111>

Lehman, J., Clune, J., Misevic, D., Adami, C., Altenberg, L., Beaulieu, J., Bentley, P. J., Bernard, S., Beslon, G., Bryson, D. M., Cheney, N., Chrabaszcz, P., Cully, A., Doncieux, S., Dyer, F. C., Ellefsen, K. O., Feldt, R., Fischer, S., Forrest, S., ... Yosinski, J. (2020). 'The Surprising Creativity of Digital Evolution: A Collection of Anecdotes from the Evolutionary Computation and Artificial Life Research Communities', in*Artificial Life* *26*(2): 274--306.

MacAskill, W. (2022). *What We Owe The Future: A Million-Year View* (Oneworld).

Matheny, J. G. (2007). 'Reducing the Risk of Human Extinction', in *Risk Analysis* *27*(5): 1335--1344.

Metaculus. (2022a). 'By 2100, will the human population decrease by at least 10% during any period of 5 years?'. *Metaculus*.<https://www.metaculus.com/questions/1493/global-population-decline-10-by-2100/>

Metaculus. (2022b). 'If a global catastrophe occurs, will it be due to biotechnology or bioengineered organisms?'. *Metaculus*. <https://www.metaculus.com/questions/1502/ragnar%25C3%25B6k-question-series-if-a-global-catastrophe-occurs-will-it-be-due-to-biotechnology-or-bioengineered-organisms/>

Metaculus. (2022c). 'Will there be a global thermonuclear war by 2070?'. *Metaculus*. <https://www.metaculus.com/questions/3517/will-there-be-a-global-thermonuclear-war-by-2070/>

Michigan, et al. V. Environmental Protection Agency, et al. (No. 14-46); Utility Air Regulatory Group v. Environmental Protection Agency, et al. (No. 14-47); National Mining Association v. Environmental Protection Agency, et al. (No. 14-49), No. 14-46 (135 Supreme Court of the United States 2699 29 July 2015).

Millett, P., and Snyder-Beattie, A. (2017). 'Existential Risk and Cost-Effective Biosecurity', in *Health Security* *15*(4): 373--383.

Mills, M. J., Toon, O. B., Lee-Taylor, J. M., and Robock, A. (2014). 'Multi-Decadal Global Cooling and Unprecedented Ozone Loss Following a Regional Nuclear Conflict', in *Earth's Future* *2*(4): 161--176.

Muehlhauser, L. (2021). 'Treacherous turns in the wild'. <https://lukemuehlhauser.com/treacherous-turns-in-the-wild/>

Murphy, T. (2013). 'The First Level of Super Mario Bros is Easy with Lexicographic Orderings and Time Travel'. <http://www.cs.cmu.edu/~tom7/mario/mario.pdf> National Standards to Prevent, Detect, and Respond to Prison Rape, 77

Federal Register 37106 (June 20, 2012) (codified at 28 Code of Federal Regulations, pt. 115). (2012).

Neumann, P. J., Cohen, J. T., and Weinstein, M. C. (2014). 'Updating cost-effectiveness---The curious resilience of the \$50,000-per-QALY threshold', in *The New England Journal of Medicine* *371*(9): 796--797. Nondiscrimination on the Basis of Disability in State and Local

Government Services, 75 Federal Register 56164 (Sept. 15, 2010) (codified at 28 Code of Federal Regulations, pt. 35). (2010).

Nuclear Threat Initiative. (2020a). *Preventing the Next Global Biological Catastrophe* (Agenda for the Next Administration: Biosecurity). Nuclear Threat Initiative. <https://media.nti.org/documents/Preventing_the_Next_Global_Biological_Catastrophe.pdf>

Nuclear Threat Initiative. (2020b). *Reducing Nuclear Risks: An Urgent Agenda for 2021 and Beyond* (Agenda for the Next Administration: Nuclear Policy). Nuclear Threat Initiative. <https://media.nti.org/documents/Reducing_Nuclear_Risks_An_Urgent_Agenda_for_2021_and_Beyond.pdf>

Oficina de Administración y Presupuesto de EE.UU. (2022). *Budget of the U.S. Government: Fiscal Year 2023*. 04/08/2022. <https://www.whitehouse.gov/wp-content/uploads/2022/03/budget_fy2023.pdf>

Ohio v. U.S. Dept. Of the Interior, 880 F. 2d 432 (Court of Appeals, Dist. of Columbia Circuit 1989).

OpenAI. (2017). 'Learning from Human Preferences'. <https://openai.com/blog/deep-reinforcement-learning-from-human-preferences/>

Ord, T. (2015). 'Moral Trade', in *Ethics* *126*(1): 118--138.

Ord, T. (2020). *The Precipice: Existential Risk and the Future of Humanity* (Bloomsbury).

Our World in Data. (2019). 'Number of deaths by cause, United States, 2019'. *Our World in Data*. <https://ourworldindata.org/grapher/annual-number-of-deaths-by-cause?country=~USA>

Our World in Data. (2022). 'Daily and total confirmed COVID-19 deaths, United States'. *Our World in Data*. <https://ourworldindata.org/grapher/total-daily-covid-deaths>

Parfit, D. (1984). *Reasons and Persons* (Clarendon Press).

PopulationPyramid. (2019). 'Population pyramid for the United States of America, 2033'. PopulationPyramid.Net. <https://www.populationpyramid.net/united-states-of-america/2033/>

Posner, E. A., and Sunstein, C. R. (2017). 'Moral Commitments in Cost-Benefit Analysis', in *Virginia Law Review* *103*: 1809--1860.

Posner, R. (2004). *Catastrophe: Risk and Response* (Oxford University Press).

Reisner, J., D'Angelo, G., Koo, E., Even, W., Hecht, M., Hunke, E.,

Comeau, D., Bos, R., and Cooley, J. (2018). 'Climate Impact of a Regional Nuclear Weapons Exchange: An Improved Assessment Based On Detailed Source Calculations', in *Journal of Geophysical Research: Atmospheres* *123*(5): 2752--2772.